Série Infiniband CS7500

La croissance actuelle considérable des données et le traitement des données en temps réel exigent des interconnexions plus rapides et plus efficaces pour le calcul haute performance (HPC), le cloud et les data centers hyperscale. Les commutateurs NVIDIA®Mellanox®CS7500 offrent une faible latence et une bande passante de 100 Gbit/s dans un châssis jusqu’à 28 U, avec une bande passante garantie et une qualité de service granulaire. Grâce à ses capacités innovantes, la série CS7500 offre des performances système élevées, une utilisation optimale du réseau et elle est évolutive.

Rendre les data centers évolutifs

La série de commutateurs Smart Director NVIDIA Mellanox CS7500 offre jusqu’à 648 ports EDR (Enhanced Data Rate) 100 Gbit/s, ce qui permet d’utiliser une solution de fabrique haute performance pour les infrastructures HPC, d’IA, de cloud et de data centers hyperscale dans un facteur de forme jusqu’à 28 U. Sa conception intelligente offre des niveaux de performance sans précédent et simplifie la création de clusters pouvant évoluer jusqu’à des milliers de nœuds. En outre, les feuilles (leaf), les troncs (spine), les modules de gestion, les blocs d’alimentation et les unités de ventilateur sont tous remplaçables à chaud, ce qui élimine les temps d’arrêt.

POINTS FORTS

VITESSE DE LIAISON

100GB/S

NOMBRE DE PORTS

648 de type EDR

DÉBIT MAX.

130Tb/s

TAILLE DU CHÂSSIS

28U

CONSOMMATION ÉLECTRIQUE (ATIS)

6.4KW

PERFORMANCES INFINIBAND DE PREMIER ORDRE

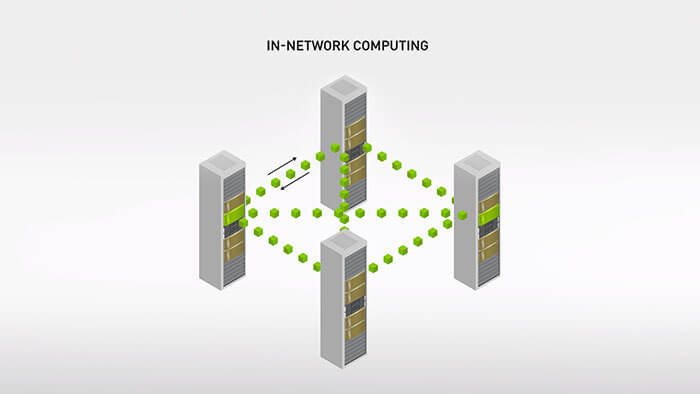

Informatique en réseau

La technologie informatique en réseau NVIDIA Mellanox Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ décharge le processeur des opérations de communication collective au profit du réseau de commutation, améliorant ainsi considérablement les performances des applications.

Auto-réparation de la mise en réseau

Le système InfiniBand Mellanox de NVIDIA avec fonctionnalités d’auto-réparation de la mise en réseau permet de surmonter les pannes de liaison et d’obtenir une restauration du réseau 5 000 fois plus rapide qu’une solution logicielle, ce qui améliore les performances du système, l’utilisation du réseau et rend ce dernier évolutif.

Gestion UFM

Les plateformes NVIDIA Mellanox UFM® (Unified Fabric Management) associent des capacités avancées de télémétrie réseau en temps réel à des systèmes de cyber-intelligence et d’analyses de données entièrement optimisés par l’IA pour améliorer l’utilisation des ressources de la fabrique et offrir un avantage compétitif, tout en réduisant les coûts d’exploitation.

Principales caractéristiques

- Jusqu’à 648 ports EDR 100 Gbit/s dans un commutateur 28 U

- Capacité de commutation jusqu’à 130 Tbit/s.

- Latence ultra-faible

- Conforme aux spécifications 1.3 et 1.2.1 de l’InfiniBand Trade Association (IBTA)

- Application de la qualité de service

- Alimentation N+N.

- Agent de gestion de sous-réseau intégré (jusqu’à 2 000 nœuds)

- Une fabrique rapide et efficace

- Gestion complète du châssis

- Interface de ligne de commande intuitive (CLI) et interface utilisateur graphique (GUI) pour un accès facile

- Peut être amélioré avec UFM

- Capteurs de température et moniteurs de tension

- Vitesse du ventilateur contrôlée par le logiciel de gestion

Avantages

- Retour sur investissement élevé : efficacité énergétique, coûts réduits et hautes performances évolutives

- Fabrique haute performance pour le calcul parallèle ou la convergence entrée/sortie (E/S)

- Jusqu’à 648 ports pour des modules évolutifs

- Fabrique à bande passante élevée et à faible latence pour les applications à forte intensité de calcul

- Configuration et gestion rapides et faciles

- Optimise les performances en éliminant les congestions de la fabrique

- Gestion de fabrique pour les applications de cluster et d’E/S convergées

Tableau comparatif de la série CS7500

| Link Speed | Ports | Height | Switching Capacity | Cooling System | Spine Modules | Leaf Modules | Interface | Management Module | Number of PSUs | |

| CS7500 | 100Gb/s | 648 | 28U | 130Tb/s | 20 fans | 18 | 18 | QSFP28 | 1–2 | 10 |

| CS7510 | 100Gb/s | 324 | 16U | 64.8Tb/s | 12 fans | 9 | 9 | QSFP28 | 1–2 | 6 |

| CS7520 | 100Gb/s | 216 | 12U | 43.2Tb/s | 8 fans | 6 | 6 | QSFP28 | 1–2 | 4 |

Contact Our Team

If you need more information about our products do not hesitate to contact our dedicated team.

Contact Us