CS7500 Infiniband Series

Das massive Datenwachstum der heutigen Zeit und die Datenverarbeitung in Echtzeit erfordern schnellere und effizientere Verbindungen für High-Performance-Computing (HPC), Cloud und Hyperscale-Rechenzentren. NVIDIA® Mellanox® CS7500 Switches bieten niedrige Latenzzeiten und eine Bandbreite von 100 GB/s in einem Gehäuse von bis zu 28U, mit garantierter Bandbreite und granularer Servicequalität. Die innovativen Funktionen der CS7500-Serie sorgen für eine hohe Systemleistung, Skalierbarkeit und eine optimale Netzwerkauslastung.

Skalierung von Rechenzentren

Die Smart Director Switches der NVIDIA Mellanox CS7500-Serie bieten bis zu 648 EDR-100GB/s-Ports (Enhanced Data Rate) und ermöglichen so eine leistungsstarke Fabric-Lösung für HPC-, KI-, Cloud- und Hyperscale-Rechenzentrumsinfrastrukturen in einem Formfaktor von bis zu 28U. Sein intelligentes Design bietet ein beispielloses Leistungsniveau und vereinfacht den Aufbau von Clustern, die bis zu Tausenden von Knoten skalieren können. Darüber hinaus sind die Leaf-Blades, Spine-Blades, Management-Module, Netzteile und Lüftereinheiten im laufenden Betrieb austauschbar, wodurch Ausfallzeiten vermieden werden.

HÖHEPUNKTE

LINK-GESCHWINDIGKEIT

100GB/S

ANZAHL DER PORTS

648EDR

MAX. DURCHSATZ

130Tb/s

GEHÄUSEGRÖSSE

28U

STROMVERBRAUCH (ATIS)

6.4KW

WELTKLASSE INFINIBAND-LEISTUNG

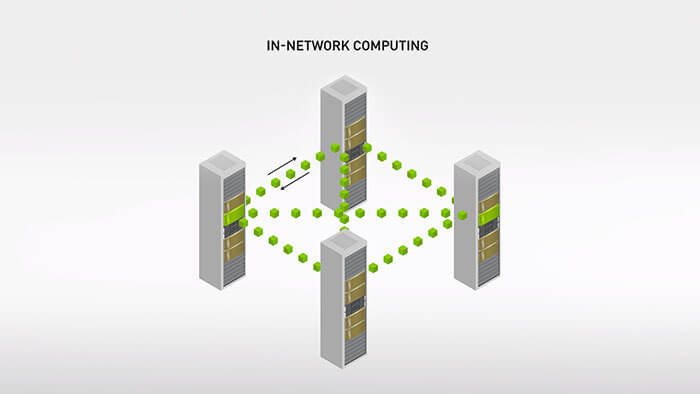

In-Network-Computing

Die NVIDIA Mellanox Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ In-Network Computing Technologie verlagert kollektive Kommunikationsvorgänge von der CPU auf das Switch-Netzwerk und verbessert so die Anwendungsleistung um eine Größenordnung.

Selbstheilende Netzwerke

NVIDIA Mellanox InfiniBand mit selbstheilenden Netzwerkfunktionen überbrückt Verbindungsausfälle und erreicht eine 5.000 Mal schnellere Netzwerkwiederherstellung als jede softwarebasierte Lösung.

UFM-Verwaltung

Die Plattformen von NVIDIA Mellanox Unified Fabric Management (UFM®) kombinieren erweiterte Echtzeit-Netzwerktelemetrie mit KI-gestützter Cyber-Intelligenz und -Analyse, um eine höhere Auslastung der Fabric-Ressourcen und einen Wettbewerbsvorteil zu erzielen und gleichzeitig die Betriebskosten zu senken.

Wesentliche Eigenschaften

- Bis zu 648 EDR 100 GB/s-Ports in einem 28U-Switch

- Bis zu 130 TB/s Switching-Kapazität

- Ultra-niedrige Latenz

- Konform mit den Spezifikationen 1.3 und 1.2.1 der InfiniBand Trade Association (IBTA)

- Durchsetzung von Quality-of-Service

- N+N-Stromversorgung

- Integrierter Subnetzmanager-Agent (bis zu 2k Knoten)

- Schnelles und effizientes Fabric Bringup

- Umfassendes Chassis-Management

- Intuitive Befehlszeilenschnittstelle („Command-Line Interface“, CLI) und grafische Benutzeroberfläche („Graphical User Interface“, GUI) für einfachen Zugriff

- Kann mit UFM erweitert werden

- Temperatursensoren und Spannungsüberwachung

- Steuerung der Lüftergeschwindigkeit durch Management-Software

Vorteile

- Hoher ROI – Energieeffizienz, Kosteneinsparungen und skalierbare hohe Leistung

- Leistungsstarke Fabric für parallele Berechnungen oder Konvergenz von Eingabe/Ausgabe (E/A)

- Bis zu 648 Ports für modulare Skalierbarkeit

- Fabric mit hoher Bandbreite und niedriger Latenz für rechenintensive Anwendungen

- Schnelle und einfache Einrichtung und Verwaltung

- Maximiert die Leistung durch Beseitigung von Fabric-Staus

- Fabric-Management für Cluster- und konvergierte E/A-Anwendungen

Vergleichstabelle der CS7500-Serie

| Link Speed | Ports | Height | Switching Capacity | Cooling System | Spine Modules | Leaf Modules | Interface | Management Module | Number of PSUs | |

| CS7500 | 100Gb/s | 648 | 28U | 130Tb/s | 20 fans | 18 | 18 | QSFP28 | 1–2 | 10 |

| CS7510 | 100Gb/s | 324 | 16U | 64.8Tb/s | 12 fans | 9 | 9 | QSFP28 | 1–2 | 6 |

| CS7520 | 100Gb/s | 216 | 12U | 43.2Tb/s | 8 fans | 6 | 6 | QSFP28 | 1–2 | 4 |

Contact Our Team

If you need more information about our products do not hesitate to contact our dedicated team.

Contact Us