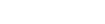

Infiniband Adapters ConnectX-6 VPI

Intelligent NVIDIA® Mellanox® ConnectX®-6 Adapterkarten bieten hohe Leistung und NVIDIA In-Network Computing Beschleunigungs-Engines zur Maximierung der Effizienz von High-Performance Computing (HPC), künstlicher Intelligenz (KI), Cloud, Hyperscale und Speicherplattformen.

Single/Dual Port Adapter mit Unterstützung für 200 GB/s

ConnectX-6 Virtual Protocol Interconnect® (VPI) Adapterkarten bieten bis zu zwei Ports mit einem Durchsatz von 200 GB/s für InfiniBand- und Ethernet-Konnektivität und eine eine extrem niedrige Latenz, liefern 215 Millionen Nachrichten pro Sekunde und verfügen über innovative Smart Offloads und netzwerkinterne Rechenbeschleunigungen, die Leistung und Effizienz steigern.

ConnectX-6 ist eine bahnbrechende Ergänzung der ConnectX-Serie branchenführender Adapterkarten und bietet innovative Funktionen wie In-Network-Speicherfunktionen, MPI-Tag-Matching-Hardwarebeschleunigung, Out-of-Order-RDMA-Schreib- und Lesevorgänge sowie Staukontrolle über die Bandbreiten HDR, HDR100, EDR und FDR InfiniBand.

HIGHLIGHTS

PORT-GESCHWINDIGKEITEN

2×200Gb/s

GESAMTBANDBREITE

200Gb/s

NACHRICHTENRATE

215 Millionen Nachr./Sek.

PCIe LANES

32x Gen3/Gen4

EINSATZBEREICHE ANWENDUNGEN

High-Performance Computing (HPC)

ConnectX-6 bietet den höchsten Durchsatz und die höchste Nachrichtenrate in der Branche und ist das perfekte Produkt, um HPC-Rechenzentren zu Exascale-Leistung und Skalierbarkeit zu führen.

ConnectX-6 bietet Verbesserungen für HPC-Infrastrukturen durch MPI-Beschleunigung und Offload sowie Unterstützung für atomare Netzwerk- und PCIe-Atomoperationen.

Maschinenlernen und KI

Maschinenlernen ist auf hohen Durchsatz und geringe Latenz angewiesen, um tiefe neuronale Netzwerke zu trainieren und die Erkennungs- und Klassifizierungsgenauigkeit zu verbessern. Als erste Adapterkarte mit einem Durchsatz von 200 GB/s, die das NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP) unterstützt, bieten ConnectX-6- und Quantum-Switches Anwendungen für maschinelles Lernen die erforderliche Leistung und Skalierbarkeit.

Speicher

NVMe-Speichergeräte gewinnen zunehmend an Bedeutung, da sie einen außergewöhnlich schnellen Remote-Direktspeicherzugriff (RDMA) auf Speichermedien bieten. Mit seinen NVMe over Fabrics (NVMe-oF) Target- und Initiator-Offloads bietet ConnectX-6 weitere Optimierungen für NVMe-oF und verbessert die CPU-Auslastung und Skalierbarkeit.

Wesentliche Eigenschaften

- HDR / HDR100 / EDR / FDR / QDR / SDR InfiniBand-Konnektivität

- Bis zu 200 GB/s Bandbreite

- Bis zu 215 Millionen Nachrichten pro Sekunde

- Niedrige Latenzzeit

- RDMA, Sende-/Empfangssemantik

- Hardware-basierte Überlastungskontrolle

- Atomare Operationen

- HDR / HDR100 / EDR / FDR / QDR / SDR InfiniBand-Konnektivität

- Bis zu 200 GB/s Bandbreite

- Bis zu 215 Millionen Nachrichten pro Sekunde

- Niedrige Latenzzeit

- RDMA, Sende-/Empfangssemantik

- Hardware-basierte Überlastungskontrolle

- Atomare Operationen

Vorteile

- Bietet den höchsten Durchsatz und die höchste Nachrichtenrate in der Branche

- Offload von Berechnungen zur Einsparung von CPU-Zyklen und Steigerung der Netzwerkeffizienz

- Höchste Leistung und intelligenteste Fabric für Rechen- und Speicherinfrastrukturen

- Unterstützung für Rechen- und Speicherplattformen auf Basis von x86, Power, Arm und GPU

Contact Our Team

If you need more information about our products do not hesitate to contact our dedicated team.

Contact Us